Robots.txt è un file di testo che consente a un sito web di fornire istruzioni ai bot di scansione del web.

Indica ai motori di ricerca come Google quali parti del tuo sito web possono e non possono accedere durante l'indicizzazione del tuo sito.

Ciò rende robots.txt uno strumento potente per la SEO e può anche essere utilizzato per garantire che determinate pagine non appaiano nei risultati di ricerca di Google.

Come funziona Robots.txt?

Robots.txt è un file di testo che puoi creare per indicare ai bot dei motori di ricerca quali pagine scansionare e indicizzare sul tuo sito web. È normalmente memorizzato nella directory principale del tuo sito web.

I motori di ricerca come Google utilizzano crawler web, a volte chiamati robot web, per archiviare e categorizzare i siti web. La maggior parte dei bot è configurata per cercare un file robots.txt sul server prima di leggere qualsiasi altro file dal sito web. Un bot fa ciò per vedere se il proprietario di un sito web ha istruzioni speciali sulla scansione e l'indicizzazione del proprio sito.

Il file robots.txt contiene un insieme di istruzioni che richiedono al bot di ignorare file o directory specifici. Ciò può essere per motivi di privacy o perché il proprietario del sito web ritiene che il contenuto di tali file e directory sia irrilevante per la categorizzazione del sito web nei motori di ricerca.

Ecco un esempio di file robots.txt:

User-Agent: *

Allow: /wp-content/uploads/

Disallow: /wp-content/plugins/

Disallow: /wp-admin/

Sitemap: https://example.com/sitemap_index.xml

In questo esempio, l'asterisco '*' dopo 'User-Agent' specifica che le istruzioni sono per tutti i motori di ricerca.

Successivamente, consentiamo ai motori di ricerca di scansionare e indicizzare i file nella nostra cartella di caricamenti di WordPress. Quindi, impediamo loro di scansionare e indicizzare le cartelle dei plugin e dell'amministrazione di WordPress.

Nota che se non disabiliti un URL, i bot dei motori di ricerca presumeranno di poterlo indicizzare.

Infine, abbiamo fornito l'URL della nostra sitemap XML.

Come creare un file Robots.txt in WordPress

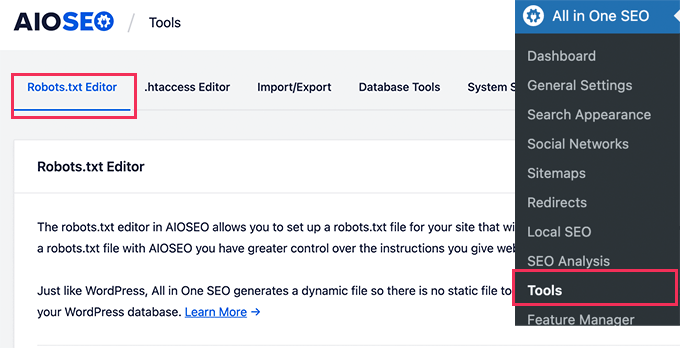

Il modo più semplice per creare un file robots.txt è utilizzare All in One SEO. È il miglior plugin SEO per WordPress sul mercato e include un generatore di file robots.txt facile da usare.

Un altro strumento che puoi utilizzare è WPCode, un potente plugin per snippet di codice che ti consente di aggiungere facilmente e in sicurezza codice personalizzato al tuo sito web. La versione Pro include una comoda funzionalità che ti permette di modificare rapidamente il file robots.txt.

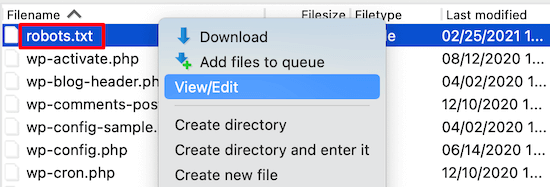

Tuttavia, se hai familiarità con il codice, puoi creare il file robots.txt manualmente. Dovrai utilizzare un client FTP per modificare il file robots.txt. In alternativa, puoi utilizzare il file manager fornito dal tuo hosting WordPress.

Per maggiori dettagli sulla creazione di un file robots.txt, consulta la nostra guida su come ottimizzare il tuo robots.txt di WordPress per la SEO.

Come usare Robots.txt per impedire ai motori di ricerca di scansionare un sito

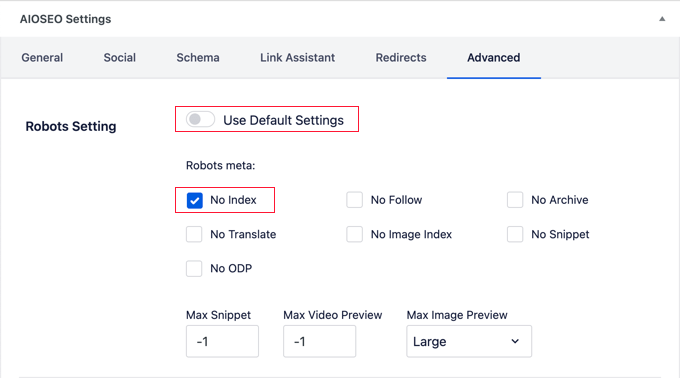

I motori di ricerca sono la principale fonte di traffico per la maggior parte dei siti web. Tuttavia, ci sono alcuni motivi per cui potresti voler scoraggiare i motori di ricerca dall'indicizzare il tuo sito.

Ad esempio, se stai ancora costruendo il tuo sito web, non vorrai che appaia nei risultati di ricerca. Lo stesso vale per blog privati e intranet aziendali.

Puoi utilizzare le regole di disallow nel tuo file robots.txt per chiedere ai motori di ricerca di non indicizzare l'intero sito web o solo determinate pagine. Troverai istruzioni dettagliate nella nostra guida su come impedire ai motori di ricerca di eseguire la scansione di un sito WordPress.

Puoi utilizzare strumenti come All in One SEO per aggiungere automaticamente queste regole al tuo file robots.txt.

È importante notare che non tutti i bot rispetteranno un file robots.txt. Alcuni bot malevoli leggeranno persino il file robots.txt per scoprire quali file e directory dovrebbero colpire per primi.

Inoltre, anche se un file robots.txt istruisce i bot a ignorare pagine specifiche del sito, tali pagine potrebbero comunque apparire nei risultati di ricerca se sono collegate ad altre pagine sottoposte a scansione.

Speriamo che questo articolo ti abbia aiutato a saperne di più su robots.txt in WordPress. Potresti anche voler consultare il nostro elenco di Letture aggiuntive qui sotto per articoli correlati su utili suggerimenti, trucchi e idee per WordPress.

Se ti è piaciuto questo articolo, iscriviti al nostro canale YouTube per tutorial video su WordPress. Puoi anche trovarci su Twitter e Facebook.

Letture aggiuntive

- Come aggiungere il tuo sito WordPress a Google Search Console

- SEO

- Come impedire ai motori di ricerca di scansionare un sito WordPress

- Cos'è una Sitemap XML? Come creare una Sitemap in WordPress

- Come nascondere una pagina WordPress da Google (4 metodi)

- Come ottimizzare il tuo file Robots.txt di WordPress per la SEO