小さな見落としがちなテキストファイルが、静かにウェブサイトのSEOを妨害している可能性があると気づいたときの、あの沈み込むような感覚。多くのサイトオーナーは、robots.txtファイルにある簡単な間違いが、Googleが最も重要なコンテンツを見つけるのを妨げていることに気づいていません。

何千ものWordPressサイトを監査した後、私たちは数え切れないほどこの状況を目にしてきました。良いニュースは、それを修正するのがあなたが思うよりも簡単であるということです。

このガイドでは、WordPressのrobots.txtファイルを最適化するために私たちが使用する、実証済みの正確な手順を説明します。正しく設定し、検索エンジンが効率的にサイトをクロールできるようにする方法を学びます。

圧倒されていますか?このガイドでカバーするすべての内容の簡単な概要を以下に示します。興味のあるセクションに自由にジャンプしてください。

robots.txtファイルとは何ですか?

Robots.txt は、ウェブサイトの所有者が作成できるテキストファイルで、検索エンジンのボットにサイト上のページをどのようにクロールおよびインデックスするかを指示します。

通常、ウェブサイトのルートディレクトリ(メインフォルダとも呼ばれます)に保存されます。robots.txtファイルの基本的な形式は次のようになります:

User-agent: [user-agent name]

Disallow: [URL string not to be crawled]

User-agent: [user-agent name]

Allow: [URL string to be crawled]

Sitemap: [URL of your XML Sitemap]

特定のURLを許可または禁止するための複数の指示行を含め、複数のサイトマップを追加できます。URLを禁止しない場合、検索エンジンのボットはそれをクロールできると想定します。

robots.txtの例ファイルは次のようになります。

User-Agent: *

Allow: /wp-content/uploads/

Disallow: /wp-content/plugins/

Disallow: /wp-admin/

Sitemap: https://example.com/sitemap_index.xml

上記のrobots.txtの例では、検索エンジンがWordPressのアップロードフォルダ内のファイルをクロールおよびインデックスすることを許可しています。

その後、プラグインとWordPress管理フォルダのクロールとインデックス作成を検索ボットに禁止しました。

最後に、XMLサイトマップのURLを提供しました。

WordPressサイトにrobots.txtファイルは必要ですか?

robots.txt ファイルがなくてもサイトは機能しますが、最適化された robots.txt ファイルを持つサイトは検索結果でより良いパフォーマンスを発揮することが一貫してわかっています。

さまざまな業界のクライアントとの連携を通じて、robots.txt による適切なクロールバジェット管理が、重要なコンテンツのインデックス作成を迅速化し、全体的な SEO パフォーマンスを向上させることを実感しています。

これは、ブログを始めたばかりで、まだコンテンツがあまりない場合には、あまり影響がありません。

ただし、ウェブサイトが成長し、コンテンツが増えるにつれて、ウェブサイトがどのようにクロールおよびインデックスされるかについて、より詳細な制御が必要になる可能性が高くなります。

その理由は次のとおりです。

検索エンジンは、Googleが「クロールバジェット」と呼ぶものを各ウェブサイトに割り当てます。これは、指定された期間内にクロールするページの数です。

数千ものWordPressサイトでのテストを通じて、大規模なサイトは戦略的なrobots.txt構成を通じてこの予算を最適化することから特に恩恵を受けることがわかりました。

例えば、当社のエンタープライズクライアントの 1 社は、推奨される robots.txt の最適化を実装した後、クロール効率が 40% 向上しました。

WordPressの管理ページ、プラグインファイル、テーマフォルダなど、検索ボットにクロールさせたくないページへのアクセスを拒否できます。

不要なページを禁止することで、クロールクォータを節約できます。これにより、検索エンジンはサイト上のさらに多くのページをクロールし、できるだけ早くインデックスできるようになります。

robots.txtファイルを使用するもう1つの良い理由は、検索エンジンがウェブサイト上の投稿やページをインデックスに登録するのを停止したい場合です。

ただし、robots.txtはコンテンツを隠すのに最適な方法ではないことを知っておくことが重要です。他のウェブサイトからリンクされている場合、disallowedページは検索結果に表示される可能性があります。

ページがGoogleに表示されないように確実にしたい場合は、代わりに「noindex」メタタグを使用する必要があります。これは、検索エンジンにページをインデックスに追加しないように指示します。

理想的なrobots.txtファイルとはどのようなものですか?

多くの人気ブログでは非常にシンプルなrobots.txtファイルを使用しています。その内容は、特定のサイトのニーズによって異なる場合があります。

User-agent: *

Disallow:

Sitemap: https://www.example.com/post-sitemap.xml

Sitemap: https://www.example.com/page-sitemap.xml

このrobots.txtファイルは、すべてのボットがすべてのコンテンツをインデックスすることを許可し、ウェブサイトのXMLサイトマップへのリンクを提供します。

WordPressサイトの場合、robots.txtファイルには以下のルールをお勧めします。

User-Agent: *

Allow: /wp-content/uploads/

Disallow: /wp-admin/

Disallow: /readme.html

Disallow: /refer/

Sitemap: https://www.example.com/post-sitemap.xml

Sitemap: https://www.example.com/page-sitemap.xml

これは、検索ボットにWordPressのすべての画像とアップロードされたファイルをインデックスするように指示します。これは、Googleのような検索エンジンが理解する便利なコマンドであるAllowディレクティブを具体的に使用します。

これにより、WordPressの管理画面、デフォルトのreadme.htmlファイル(WordPressのバージョンが明らかになる可能性があります)、および/refer/のようなクロークされたアフィリエイトリンクの一般的なディレクトリへの検索ボットによるインデックス作成が禁止されます。

robots.txt ファイルに サイトマップ を追加することで、Google ボットがサイト上のすべてのページを見つけやすくなります。

理想的なrobots.txtファイルがどのようなものかを知ったところで、WordPressでrobots.txtファイルを作成する方法を見てみましょう。

WordPress で Robots.txt ファイルを作成する方法

WordPressでrobots.txtファイルを作成するには2つの方法があります。あなたに最適な方法を選択できます。

All in One SEO を使用して robots.txt ファイルを編集する方法 1

All in One SEO (AIOSEO とも呼ばれる) は、300万以上のウェブサイトで使用されている、市場で最高の WordPress SEO プラグインです。使いやすく、robots.txt ファイルジェネレーターも付属しています。

詳細については、詳細な AIOSEOレビューをご覧ください。

AIOSEOプラグインがまだインストールされていない場合は、WordPressプラグインのインストール方法に関するステップバイステップガイドをご覧ください。

注: AIOSEOの無料版も利用可能で、この機能があります。

プラグインがインストールされ有効化されると、WordPress管理画面から直接robots.txtファイルを作成および編集するために使用できます。

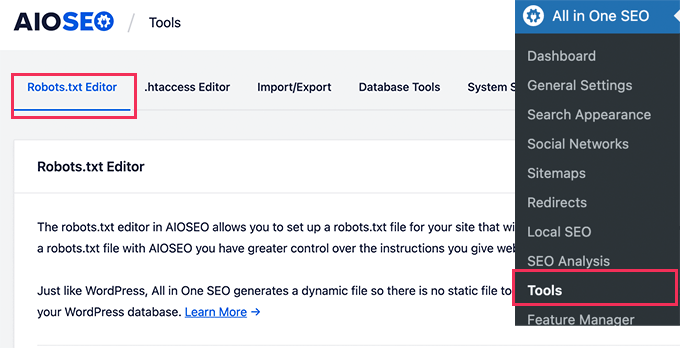

All in One SEO » Tools にアクセスして、robots.txt ファイルを編集してください。

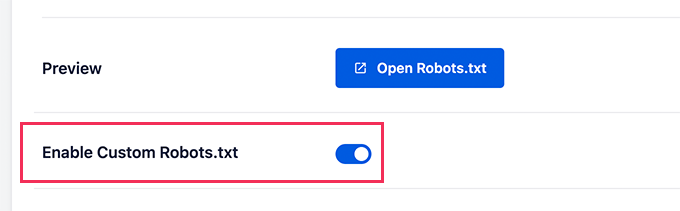

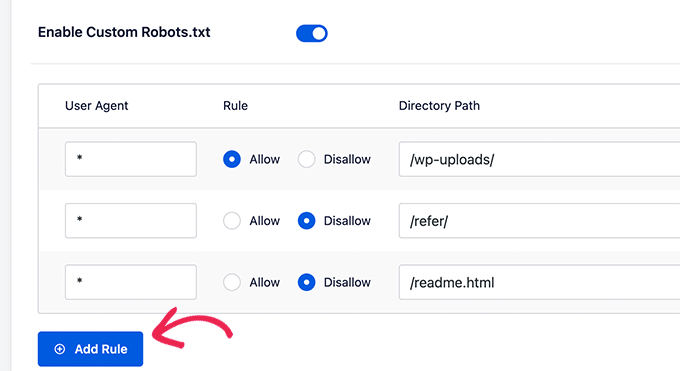

まず、「カスタムrobots.txtを有効にする」トグルを青色にクリックして、編集オプションをオンにする必要があります。

このトグルをオンにすると、WordPressでカスタムrobots.txtファイルを作成できます。

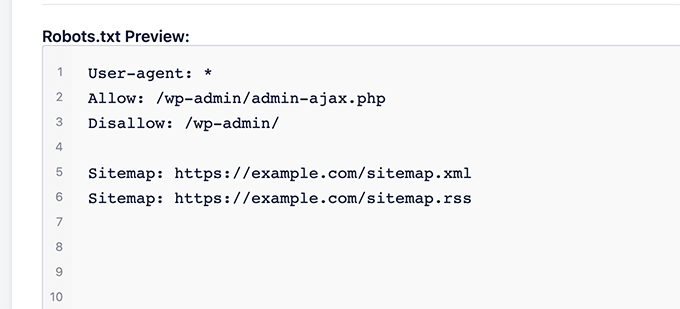

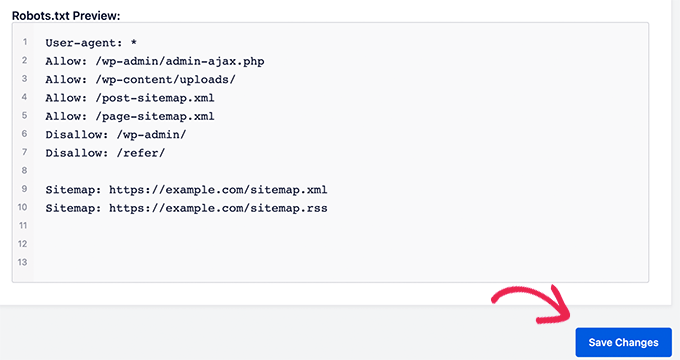

All in One SEOは、画面下部の「Robots.txtプレビュー」セクションに既存のrobots.txtファイルを表示します。

このバージョンでは、WordPress によって追加されたデフォルトのルールが表示されます。

これらのデフォルトルールは、検索エンジンに WordPress のコアファイルをクロールしないように指示し、ボットがすべてのコンテンツをインデックスできるようにし、サイトの XML サイトマップへのリンクを提供します。

これで、SEOのためにrobots.txtを改善するために独自のカスタムルールを追加できます。

ルールを追加するには、「User Agent」フィールドにユーザーエージェントを入力します。「*」を使用すると、すべてのユーザーエージェントにルールが適用されます。

次に、検索エンジンにクロールを「許可」するか「禁止」するかを選択します。

次に、「Directory Path」フィールドにファイル名またはディレクトリパスを入力します。

ルールは自動的に robots.txt に適用されます。別のルールを追加するには、「ルールの追加」ボタンをクリックするだけです。

上記で共有した理想的なrobots.txt形式を作成するまで、ルールを追加することをお勧めします。

カスタムルールは次のようになります。

完了したら、「変更を保存」ボタンをクリックして変更を保存することを忘れないでください。

方法2:WPCodeを使用したrobots.txtファイルの編集

WPCodeは、カスタムコードを簡単かつ安全にウェブサイトに追加できる強力なコードスニペットプラグインです。

また、robots.txt ファイルをすばやく編集できる便利な機能も含まれています。

注意: WPCode Free Pluginもありますが、ファイルエディタ機能は含まれていません。

まず、WPCodeプラグインをインストールする必要があります。手順については、WordPressプラグインのインストール方法に関する初心者向けガイドをご覧ください。

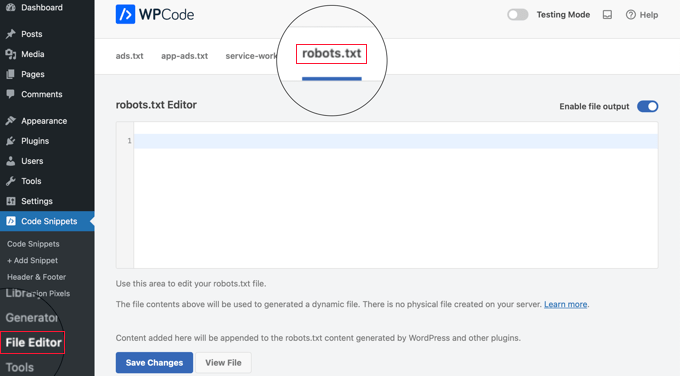

有効化すると、WPCode » ファイルエディター ページに移動する必要があります。そこに表示されたら、ファイルを編集するために「robots.txt」タブをクリックするだけです。

これで、robots.txt ファイルの内容を貼り付けるか、入力できます。

終了したら、ページ下部にある「変更を保存」ボタンをクリックして設定を保存してください。

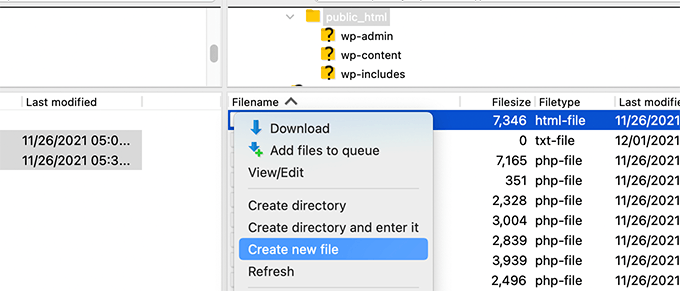

方法3:FTPを使用してrobots.txtファイルを手動で編集する

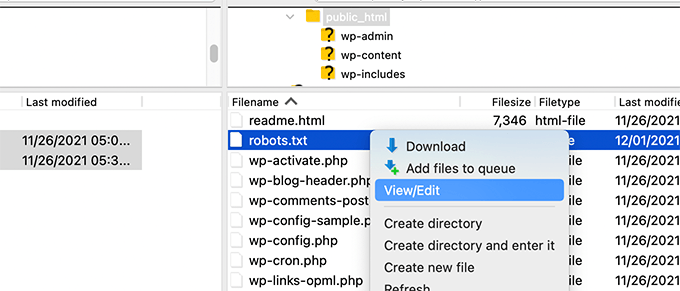

この方法では、FTPクライアントを使用してrobots.txtファイルを編集する必要があります。または、WordPressホスティングで提供されているファイルマネージャーを使用することもできます。

プロのヒント: 編集する前に、元のrobots.txtファイル(存在する場合)のバックアップコピーをコンピューターにダウンロードすることをお勧めします。そうすれば、問題が発生した場合に簡単に再アップロードできます。

FTPクライアントを使用して、WordPressウェブサイトのファイルに接続するだけです。

サイトに入ると、ウェブサイトのルートフォルダに robots.txt ファイルが表示されます。

表示されない場合は、robots.txt ファイルがない可能性が高いです。

その場合は、そのまま作成できます。

robots.txt はプレーンテキストファイルなので、コンピューターにダウンロードして、Notepad や TextEdit のような任意のプレーンテキストエディタで編集できます。

変更を保存した後、robots.txt ファイルをウェブサイトのルートフォルダにアップロードし直すことができます。

Robots.txt ファイルをテストする方法

robots.txtファイルを作成または編集した後、エラーがないか確認するのは良い考えです。小さなタイプミスが検索エンジンから重要なページを誤ってブロックする可能性があるため、この手順は非常に重要です!👍

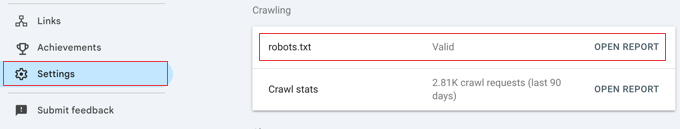

Googleには以前は専用のテストツールがありましたが、現在はその機能をメインのGoogle Search Consoleレポートに統合しています。

まず、サイトがGoogle Search Consoleに接続されていることを確認してください。まだ行っていない場合は、WordPressサイトをGoogle Search Consoleに追加する方法に関する簡単なガイドに従ってください。

設定が完了したら、Google Search Consoleダッシュボードに移動します。左下のメニューにある設定に移動します。

次に、「クロール」セクションを見つけて、「robots.txt」の横にある「レポートを開く」をクリックします。

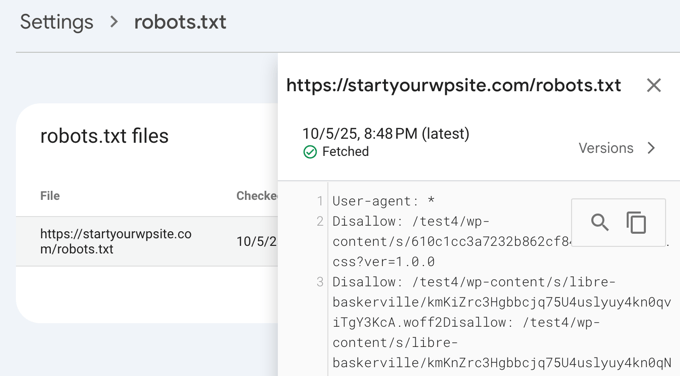

リスト内のファイルの現在のバージョンをクリックするだけです。

このレポートには、Googleが見つけたrobots.txtファイルの最新バージョンが表示されます。検出された構文エラーまたは論理的な問題が強調表示されます。

ファイルを更新したばかりで、変更がすぐにここに表示されなくても心配しないでください。Googleは、robots.txtファイルの新しいバージョンを1日に1回程度自動的にチェックします。

後でこのレポートを確認して、Googleが最新の変更を認識し、すべてが正常であることを確認できます。

最終的な考え

robots.txtファイルを最適化する目標は、公開されていないページを検索エンジンがクロールしないようにすることです。たとえば、wp-pluginsフォルダ内のページやWordPress管理フォルダ内のページなどです。

SEO専門家の間では、WordPressのカテゴリ、タグ、アーカイブページをブロックすると、クロール率が向上し、インデックス作成が速くなり、ランキングが向上するという一般的な誤解があります。

これは真実ではありません。実際、この方法はGoogleによって強く推奨されておらず、サイトの理解を助けるためのベストプラクティスガイドラインに反しています。

robots.txtファイルをウェブサイト用に作成するために、上記のrobots.txt形式に従うことをお勧めします。

WordPressのrobots.txtに関するよくある質問

WordPressでrobots.txtファイルを最適化することについて、よく寄せられる質問をいくつかご紹介します。

1. robots.txtファイルの主な目的は何ですか?

robots.txtファイルの主な目的は、ウェブサイトのクロールバジェットを管理することです。検索エンジンに無視するページ(管理ページやプラグインファイルなど)を伝えることで、最も重要なコンテンツをより効率的にクロールおよびインデックス化するためにリソースを費やすことができます。

2. WordPressではrobots.txtファイルはどこにありますか?

robots.txtファイルは、ウェブサイトのルートディレクトリにあります。通常、ウェブブラウザでyourdomain.com/robots.txtにアクセスすると表示できます。

3. robots.txtを使用すると、サイトのセキュリティを向上させることができますか?

いいえ、robots.txt はセキュリティ対策ではありません。このファイルは公開されており、リストされた URL へのアクセスを実際にブロックするものではありません。単に、礼儀正しい検索エンジンのクローラーへの指示を提供するだけです。

4. WordPress のカテゴリページとタグページを robots.txt でブロックすべきですか?

いいえ、カテゴリページとタグページをブロックすべきではありません。これらのアーカイブページは、サイトの構造を検索エンジンが理解し、コンテンツを発見するのに役立つため、SEO にとって有用です。これらをブロックすると、検索ランキングに悪影響を与える可能性があります。

WordPressでrobots.txtを使用するための追加リソース

robots.txt ファイルの最適化方法がわかったところで、WordPress で robots.txt を使用することに関連する他の記事もご覧になりたいかもしれません。

- 用語集: Robots.txt

- GoogleからWordPressのページを隠す方法

- 検索エンジンがWordPressサイトをクロールするのを停止する方法

- WordPress サイトをインターネットから完全に削除する方法

- WordPressでPDFファイルを簡単に非表示(noindex)にする方法

- WordPressで「GooglebotがCSSおよびJSファイルにアクセスできません」エラーを修正する方法

- llms.txtとは?WordPressにllms.txtを追加する方法

- WordPressのAll in One SEOを正しく設定する方法(完全ガイド)

この記事が、WordPressのrobots.txtファイルをSEOのために最適化する方法を学ぶのに役立ったことを願っています。また、初心者向けのWordPress SEO完全ガイドや、ウェブサイトを成長させるための最高のWordPress SEOツールに関する専門家のおすすめもご覧ください。

この記事が気に入ったら、WordPressのビデオチュートリアルについては、YouTubeチャンネルを購読してください。 TwitterやFacebookでもフォローできます。

デニス・ムトミ

AIOSEOプラグインを使っているのですが、何かを壊したくなかったので、「カスタムrobots.txtを有効にする」オプションは常に無視していました。しかし、この記事を読んで、サイトのrobots.txtファイルを最適化する時間をかける価値があることを確信しました。

アミット・バナジー

robots.txtのテンプレート全体が提供されていれば、役に立ったでしょう。

WPBeginnerサポート

We did include the entire robots.txt

管理者

マイケル

回答を修正した方が良いと思います。httpではなくhttpsであるべきです。プラグインファイルもdisallowするのは正しいですか?

WPBeginnerサポート

ご指摘ありがとうございます。サンプルを更新しました。プラグインを拒否する場合は、安全のために特定のプラグインを確認してください。

モイヌディン・ワヒード

robots.txtファイルに関するこの有益な投稿をありがとうございます。 ウェブサイトがGoogleボットのクロール方法を制御するためにこのファイルを維持する必要があることを知りませんでした。 始めたばかりの初心者向けウェブサイトでは、robots.txtファイルは必要ですか、それともウェブサイトのrobots.txtファイルを作成できるプラグインのような方法はありますか?

WPBeginnerサポート

ほとんどのSEOプラグインは、新しいサイトのrobots.txtの設定を支援し、ボットが本来アクセスすべきでないセクションをクロールするのを防ぎます。

管理者

イジー・ヴァネック

この記事のおかげで、robots.txt ファイルを確認し、サイトマップ付きの URL アドレスを追加しました。同時に、バリデーターによって明らかになった他の問題のある行もありました。これまで robots.txt のサイトマップについては知りませんでした。ありがとうございます。

WPBeginnerサポート

どういたしまして、ガイドがお役に立てて嬉しいです!

管理者

Stéphane

こんにちは、

その投稿、ありがとうございます。robots.txtファイルの使い方がより明確になりました。robots.txtファイルに関するアドバイスを探していると見つかるほとんどのウェブサイトで、WordPressの場合、以下のフォルダがクロールから明示的に除外されていることがわかります:

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

これらのフォルダを除外する理由がよくわかりません(実際にはありますか?)。この件について、あなたの見解はいかがですか?

WPBeginnerサポート

これは主に、ユーザーがあなたのサイトを検索したときに、それらのフォルダ内のものが結果として表示されるのを防ぐためです。それはあなたのコンテンツではないため、ほとんどの人がサイトの結果に表示させたいとは思わないでしょう。

管理者

zaid haris

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

GSCは「Disallow: /wp-admin/」のカバレッジエラーを表示しています。これは間違っていますか?

WPBeginnerサポート

ほとんどのサイトでは、wp-adminから検索結果に表示させたくないため、wp-adminのスキャンを拒否した場合にカバレッジエリアを受け取るのは問題なく、予想されることです。

管理者

Hansini

WordPressサイトのために、指示通りrobots.txtを手動で作成しています。

1つ疑問があります。User-Agent: *と書くと、他のスパムボットも私のサイトにアクセスできるようになりませんか?

User-Agent: *と書くべきか、User-Agent: Googlebotと書くべきでしょうか?

WPBeginnerサポート

User-Agent行は、サイト上のすべてのロボットが従うべきルールを設定しています。その行に特定のボットを指定すると、その特定のボットのルールが設定され、他のボットには適用されません。

管理者

ニシャント

Googleに私の投稿をインデックスさせるには、何を記述すればよいですか?

WPBeginnerサポート

サイトをリストに載せるには、以下の記事をご覧ください。

https://014.leahstevensyj.workers.dev/beginners-guide/how-do-i-get-my-wordpress-site-listed-on-google-beginners-guide/

管理者

サンジーブ・パンデイ

/wp-content/themes/ も禁止すべきですか?

google検索で site:abcdef.com コマンドを実行すると、検索結果に表示されます。

WPBeginnerサポート

テーマフォルダをブロックすることを心配する必要はありません。SEOフレンドリーなコンテンツを作成すれば、テーマが検索結果に表示されることはなくなるはずです。

管理者

サレム

こんにちは、「Disallow: /readme.html & Disallow: /refer/ 」はどういう意味ですか?

WPBeginnerサポート

これは、検索エンジンに参照リンクや readme.html ファイルを見ないように指示していることを意味します。

管理者

sean

こんにちは、wp-content/uploadsをブロックすることのメリット・デメリットは何ですか

ありがとうございます

WPBeginnerサポート

アップロードフォルダをブロックすると、検索エンジンは通常、画像などのアップロードされたコンテンツをクロールしません。

管理者

Piyush

問題を解決してくれてありがとう

WPBeginnerサポート

You’re welcome

管理者

ラビ・クマール

ロボット.txtについて非常に混乱しています。ブロガーにサイトマップを何度も送信しましたが、3、4日後に同じ問題が発生します。ロボット.txtとは何ですか?そして、それをどのように送信すればよいですか?教えてください。

WPBeginnerサポート

お客様の具体的な問題によります。以下のページをご覧ください。

https://014.leahstevensyj.workers.dev/glossary/robots-txt/

管理者

Prem

robots.txt ファイルを使用して URL またはページをインデックスしないようにした場合、Google は Search Console でエラーを表示しますか?

WPBeginnerサポート

いいえ、Googleはページをリストしませんが、ページがリストされている場合はエラーは表示されません。

管理者

バーラト

こんにちは

質問があります

Googleサーチコンソールのカバレッジの問題で、robots.txtによってブロックされているという警告を受け取りました

/wp-admin/widgets.php

私の質問は、wp-admin/widgets.phpをrobots.txtで許可しても安全かどうかということです。

WPBeginnerサポート

もし望むならできますが、Googleがクロールする必要のあるファイルではありません。

管理者

Anthony

こんにちは、/wp-admin/admin-ajax.php? を許可すべきかどうか疑問に思っています。

WPBeginnerサポート

通常は、そうすべきです。

管理者

Jaira

なぜ/wp-admin/admin-ajax.phpを許可する必要があるのか教えていただけますか?

WPBeginnerサポート

これは、検索エンジンで正しく表示するために、さまざまなテーマやプラグインによって使用されます。

Amila

こんにちは!この記事は本当に気に入りました。クロールに関するすべてが初心者なので、この件について質問させてください。最近、Googleが私のウェブサイトの1つをひどい方法でクロールおよびインデックス化し、削除されたページが検索結果に表示されています。当初、WordPressの設定で検索エンジンのインデックス作成をブロックしていませんでしたが、Googleがさらに3つのページ(これらのページも存在しません)を検索結果に表示した後、ブロックしました。そして、「検索エンジンのインデックス作成をブロックする」オプションがオンになっているのに、これがどのように起こりうるのか本当に理解できません。それで、Yoastの方法は役立ち、Googleが今回適切に私のウェブサイトをインデックス化するように私のウェブサイトの解決策になりますか?よろしくお願いします!

WPBeginnerサポート

Yoastプラグインは、サイトのページが適切にインデックスされていることを確認するのに役立つはずです。検索エンジンがサイトのクロールをブロックする前に、ページがキャッシュされていた可能性があります。

管理者

Amila

はい、そしてすべてのページから、もう存在しないものをキャッシュしました。いずれにせよ、現在のページは「discourage」設定になっているので、このままにしておく方が良いですか、それともチェックを外して、Yoastの助けを借りてGoogleに再度クロールしてインデックスに登録させる方が良いですか?ありがとうございます!あなたの記事のおかげで、すべてが簡単になりました!

WPBeginnerサポート

設定が完了したら、Googleにサイトを再クロールさせたいと思うでしょう。

プラドゥマン・クマール

こんにちは、記事はとても正確で完璧で大好きでした。

ちょっとした提案ですが、Googleコンソールが変更されたため、画像ROBOTS.TXTテスターを更新していただけると幸いです。また、Googleからrobots.txtを確認するためのリンクを追加していただけると素晴らしいです。

WPBeginnerサポート

フィードバックありがとうございます。可能な限り早く記事を更新するよう確認いたします。

管理者

Kamaljeet Singh

私のブログのrobots.txtファイルは次のとおりでした:

User-Agent: *

crawl-delay: 10

この投稿を読んだ後、推奨されるrobots.txtファイルに変更しました。crawl-delayを削除しても大丈夫ですか

WPBeginnerサポート

問題ありません。crawl-delayは、検索エンジンにサイトのクロール速度を遅くするように指示します。

管理者

reena

ロボット.textについて、とても分かりやすく説明していただき、大変満足しています。 あなたはとても良いライターです。

WPBeginnerサポート

Thank you, glad you liked our article

管理者

JJ

Disallow: /refer/ ページとは何ですか? 404エラーが出ますが、これは隠し wp ファイルですか?

編集スタッフ

当社では、ウェブサイト上のさまざまなアフィリエイトリンクにリダイレクトするために/refer/を使用しています。これらは単なるリダイレクトであり、実際のコンテンツではないため、インデックス作成したくありません。

管理者

Sagar Arakh

共有いただきありがとうございます。これは、robots.txtを理解する上で非常に役立ちました。

ご提案いただいた理想的なものにrobots.txtを更新しました。これで結果を待ちます。

WPBeginnerサポート

You’re welcome, glad you’re willing to use our recommendations

管理者

Akash Gogoi

とても参考になる記事でした。どうもありがとうございます。

WPBeginnerサポート

Glad our article was helpful

管理者

Zingylancer

私たちに関するこの有用な情報を共有していただきありがとうございます。

WPBeginnerサポート

Glad we could share this information about the robots.txt file

管理者

Jasper

更新情報ありがとうございます。Robot txtファイルに関する記事は参考になりました。新しい情報を得ることができました。ありがとうございます。新しいアイデアがあれば、引き続き教えてください。

WPBeginnerサポート

Glad our guide was helpful

管理者

Imran

ありがとうございます。WordPressにrobots.txtを追加しました。非常に良い記事です。

WPBeginnerサポート

Thank you, glad our article was helpful

管理者